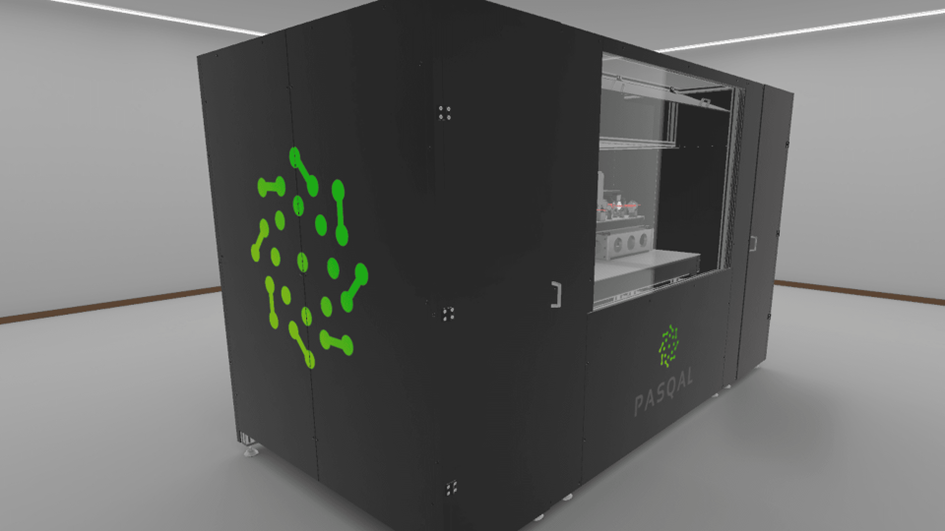

Après le Sicamore de Google, l’Eagle d’IBM, Pasqal, une startup française a présenté récemment une machine donnant corps à ce qui était de pures théories : le calcul quantique. Le résultat : des performances attendues qui surpassent tout ce qui existe à ce jour, de quoi remettre en cause de nombreux modèles numériques en cours, dont l’écosystème crypto…

En novembre dernier, une startup française a fait son petit effet en présentant son propre modèle de machine quantique. Sans entrer dans les détails, que je n’aurai pas la prétention de maîtriser, le bilan est que les calculs seraient réalisables à des vitesses inégalées. Pour se donner un ordre d’idée, Google annonçait à la présentation de son Sicamore que ce dernier pouvait réaliser un calcul complexe qui demanderait 10 000 ans au plus avancé des ordinateurs d’aujourd’hui en seulement 4 minutes. Cela été mis en doute par son concurrent IBM qui lui répondait qu’il pouvait sortir ce même résultat avec son Eagle en deux jours et demi. Quand bien même, on s’oriente vers ces ordres de grandeurs : des dizaines d’heures de calcul pour un supercalculateur réduit en une fraction de seconde sur une machine quantique.

Le temps de calcul comme bouclier

Si l’augmentation de la rapidité de calcul est un atout pour bon nombre d’applications (Big Data, IA, Météo…), cela peut devenir un vrai risque pour bien d’autres. Notamment celles qui s’appuient sur la cryptographie, et elles sont légion : le SSL, sous-couche du protocole HTTPS qui sécurise nos échanges sur internet ou nos VPN, et surtout les cryptomonnaies et blockchains associées. En effet, le principe algorithmique déployé ici s’appuie sur une double clé dont la falsification est rendue (quasi-)impossible en raison de la longueur des calculs à opérer pour y parvenir. Pour comprendre le mécanisme, imaginez un coffre-fort dont il faut retrouver la combinaison. La technique la plus connue est celle qu’on appelle la « brute force » et qui consiste à tester des milliers de combinaisons en espérant trouver la bonne. Mais tout est contraint par la taille de la clé – le nombre de mollettes que vous avez sur la porte de votre coffre-fort, ici exprimé en Bits -. Il y a quelques années, il avait fallu mettre une centaine d’ordinateurs ensemble pour « casser » une clé de 512 bits en 3 mois. Intéressant intellectuellement mais inutile sur le plan pratique. Aujourd’hui, les clés sont plutôt de 2048 bits, ce qui augmente de manière exponentielle les délais de traitement. Jusqu’à l’avènement de ces machines quantiques. On peut supposer que, soumises au même exercice de casser une clé de 2048 bits, cela ne leur prenne que quelques secondes. Une horreur ! . Car on l’a compris, la sécurité fondamentale de ces procédés s’appuie sur la difficulté à outrepasser la complexité du chiffrement… sur la base de la puissance de nos ordinateurs actuels !.

Les cryptomonnaies au premier rang

Si l’ensemble des applications cryptographiques de notre monde actuel pourrait être impacté, l’écosystème des cryptomonnaies serait le plus gravement affecté. Pour deux raisons : la première est que leur paradigme fondateur est totalement lié à cette cryptographie, selon les principes évoqués ci-avant. Fragilisez cet aspect, vous discréditez le concept, et c’est l’ensemble qui s’effondre. La seconde est évidemment l’ampleur des gains potentiels pour des esprits mal intentionnés, qui pourraient opérer lors de hold-up à grande échelle à l’aide de ces ordinateurs quantiques. Cracker votre connexion SSL pendant que vous consultez votre compte bancaire pour vous détourner au pire quelques (milliers) d’euros n’est pas intéressant face aux quelques millions de dollars stockés dans des coffres forts de gros propriétaires de cryptomonnaies.

Last but not least, l’un des mécanismes fondateurs des blockchains, la preuve de travail, pourrait lui aussi être réduit à néant. En effet, pour garantir l’intégrité de la chaine de blocs, il est nécessaire de composer un consensus fort entre les nœuds validateurs. Aussi, ce mécanisme consiste à mettre en concurrence le plus grand nombre de nœuds dans un « jeu concours ». Il s’agit de retrouver par calcul itératif une clé, de plus en plus complexe au fil du temps, si difficile à deviner que cela interdit à l’un d’eux de prendre le contrôle de la chaine et la falsifier à son profit. Les spécialistes l’appellent la règle des « 51% » : il faudrait qu’un nœud puisse à lui seul dégager un puissance de calcul au moins égale à 51% du cumul de puissance de calcul de tous les nœuds assemblés pour prendre le pouvoir sur l’opération de validation et donc sur la chaine. Mais ça, c’était avant l’arrivée des ordinateurs quantiques…

Le temps humain n’est cependant pas quantique

Il faut admettre cependant que depuis 40 ans que germe le concept d’ordinateur quantique, on n’a pas encore observé de bouleversements technologiques. Il semble en effet que, même matérialisées, ces machines quantiques ne soient pas encore vraiment maitrisées : outre que leurs fonctionnements imposent de nouveaux paradigmes algorithmiques, qu’elles soient incapables conceptuellement de traitements massifs, qu’elles ne tiennent pas encore dans une simple boite (certaines puces doivent être maintenues à 0° kelvin soit -273° Celsius), elles auraient un petit défaut, celui de produire parfois des résultats… approximatifs !

Gageons cependant que la révolution est en route et qu’il faut indéniablement s’y préparer.