Ça y est, le web3 est enfin sorti de ses nimbes et se popularise dans les médias. On y vante ses mérites : espace de plus de libertés, une totale transparence et une réelle préservation de notre vie privée. Belles ambitions. Mais on oublie de dire que ça ne sera pas gratuit. Explications.

Le web3, tel que suggéré dès 2014 par Gavin Wood, cofondateur d’Ethereum, s’articule autour du binôme blockchain et cryptomonnaie, auxquels s’ajoute la pièce essentielle des Smart Contracts, dont les NFT sont les manifestations les plus populaires. Le tout composerait un réseau d’échange et de communication totalement décentralisé, sans aucun intermédiaire ni autorité centrale, à même un jour de supplanter le web actuel. Dans l’intention, rien de neuf. Le protocole sous-jacent d’internet (le TCP/IP) est techniquement parlant sans autorité et fonctionne déjà de manière décentralisée. C’est d’ailleurs parce qu’il en est ainsi que les autres protocoles des couches supérieures, comme les blockchains, ont pu se développer. Sans lui, point de Bitcoin, point de streaming, point de réseaux sociaux… Cependant, qui dit absence d’autorité, aurait dû dire absence de contrôle des échanges et des individus. Sur la couche Web, ce n’est pas vraiment ce qui s’est passé. Quelques grands opérateurs, les fameux GAFAM, sont arrivés, par la puissance de leur offre de contenus et de services, à capter l’attention des internautes, certains diront les vampiriser, pour en tirer un profit toujours plus grand. C’est ce dont veux se libérer le Web3, dont la première explication du « 3 » viendrait de sa consonance proche de « free », libre en anglais.

Pour comprendre pourquoi nous en sommes arrivés là, procédons à une petite remise en contexte.

Le malentendu du web gratuit

Le web 1.0, tout le prouve aujourd’hui, a démarré sur un malentendu. Il a consisté à nous faire croire qu’on pouvait se divertir et s‘informer sans être obligé de payer quoi que ce soit. Rappelez-vous, la quasi-totalité des sites était à consultation libre et gratuite. Ce n’était pas parce que leur contenu n’avait pas de valeur mais parce qu’on n’envisageait pas de faire payer, c’est tout. Et ce nullement par philanthropie – même si quelques-uns s’y référaient honnêtement -, mais pour des raisons très prosaïques, dont l’une était de devoir dépasser une problématique technique : sur un réseau de portée mondiale et sans coutures, comment déployer un moyen de paiement uniforme ? Mission quasi impossible au regard de la variété des territoires couverts et de leurs réglementations locales.

Donc on a fait nativement du gratuit sur le web 1.0. Mais comme tout ça, ça ne marche pas à l’air et qu’il faut bien payer les infrastructures et les humains qui les animent, il fallait trouver des moyens de financement. On connait tous la recette : la publicité. Donc en échange de la consommation d’un service, à titre gratuit, vous êtes soumis à des messages publicitaires qui vont payer cette consommation.

Là-dessus arrive le Web 2.0, au début des années 2000. Une profusion de nouvelles approches, dont les réseaux sociaux. On passe ainsi d’un « one to many » du Web 1.0 à un « many to many », où tout le monde s’adresse à tout le monde. Et tout ça, toujours sans payer. Il faut même noter que sans cette gratuité, ces réseaux sociaux n’auraient jamais pu se développer : vous auriez payé pour pouvoir cliquer sur un pouce vers le haut vous ?

Pour assurer cette mise en relation multipartite les opérateurs de réseaux sociaux doivent bâtir et financer des infrastructures supports de plus en plus lourdes et couteuses. Ainsi, lors de son introduction en bourse en 2012, il était rapporté que pour se financer, Facebook devait dégager 100$ de recette par an et par utilisateurs, alors que la publicité de l’époque ne lui rapportait que 1$… On comprend pourquoi ses techniques publicitaires sont alors devenues de plus en plus précises, individualisées et finalement rentables.

Les promesses de la blockchain

Fin 2000, on voit apparaître le binôme blockchain/bitcoin. Sur le plan philosophique, c’est un air libertarien qui le promeut : rejet du monde financier et des banques, coupables d’avoir mis la population mondiale dans la panade lors de la crise de 2008. Sur un le plan conceptuel pur, il s’agit d’une intelligente exploitation de plusieurs technologies déjà popularisées les années précédentes, comme le Peer-to-Peer (ah ! les eMule ou Bittorrent…) et la cryptographie asymétrique type RSA. A un détail près : contrairement aux réseaux P2P gratuits, les nœuds constitutifs de la blockchain devraient être rémunérés pour leur travail, en cryptomonnaie, c’est la règle.

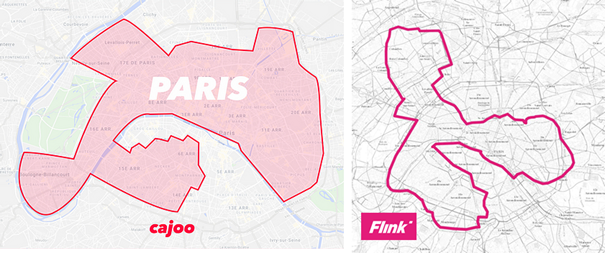

C’est ainsi qu’on arrive à un postulat de base : tout usage de la blockchain induit le paiement d’une charge destinée à rémunérer les nœuds qui la soutiennent. Et là, pas d’intermédiaire sur lequel se défausser, pas de GAFAM qui prendrait en charge ces coûts en échange de l’usage de mon profil. Non, c’est in fine du « one to one » qui s’instaure : moi, consommateur, je paie le service directement à celui qui me le fourni. Présenté ainsi, c’est d’un évident réalisme et on ne peut que y adhérer. Mais quand on entre dans le détail, ça veut dire que le moindre de mes usages actuels, et notamment sur les réseaux sociaux, devront déclencher une sortie de mon wallet, mon porte-monnaie électronique.

Devoir payer, même un pouillème de crypto, pour insulter un inconnu sur un twitter version web3, ça vous dit ? je ne suis pas certain que beaucoup y souscrivent…